Logstash是一款专业的日志管理系统。日志管理就来使用Logstash。它是一个数据处理引擎,最初用于收集日志。现在,它具有丰富的功能,可以帮助用户从不同来源收集数据,并将数据转换为服务器。该软件提供了多种配置选项,并可以设置数据输入方法。 ,您可以将数据输出存储方法设置为“是”,以便可以更轻松地管理随时间变化的配置更新。该软件非常通用,可以基于Logstash事件向Librato发送指标,注释和警报,并且可以基于预先配置的服务发送带有升级策略的通知,您可以将Logstash事件发送至Amazon Simple Storage Service,快速收集数据从多个终端,并将数据传输到指定的存储终端进行存储。如果需要此软件,请下载!

使用说明:

使用Logstash解析日志

在“存储第一个事件”中,您创建了一个基本的Logstash管道来测试Logstash设置。在现实世界中,Logstash管道更为复杂:它通常具有一个或多个输入,过滤器和输出插件。

在本部分中,您将创建一个Logstash管道,该管道使用Filebeat来获取Apache Web日志作为输入,解析这些日志以从日志中创建特定的命名字段,然后将解析后的数据写入Elasticsearch集群。无需在命令行上定义管道配置,而是在配置文件中定义管道。

配置Filebeat以将日志行发送到Logstash

在创建Logstash管道之前,将配置Filebeat以将日志行发送到Logstash。 Filebeat客户端是一种轻量级,资源友好的工具,可以从服务器上的文件收集日志,并将这些日志转发到Logstash实例进行处理。 Filebeat专为可靠性和低延迟而设计。 Filebeat在主机上仅占用很少的资源,而Beats输入插件将Logstash实例上的资源需求降至最低。

Logstash的默认安装包括Beats输入插件。 Beats输入插件允许Logstash从Elastic Beats框架接收事件,这意味着任何用Beats框架编写的Beat,例如Packetbeat和Metricbeat,也可以将事件数据发送到Logstash。

安装Filebeat之后,您需要对其进行配置。打开位于Filebeat安装目录中的filebeat.yml文件,并将内容替换为以下几行。确保路径指向logstash-tutorial.log,这是您先前下载的示例Apache日志文件:

Filebeat处理的文件的绝对路径。

保存您的更改。

为了简化配置,您将不会像实际情况那样指定TLS / SSL设置。

在数据源计算机上,使用以下命令运行Filebeat:

为Filebeat输入配置Logstash

接下来,创建一个使用Beats输入插件的Logstash配置管道,以从Beats接收事件。

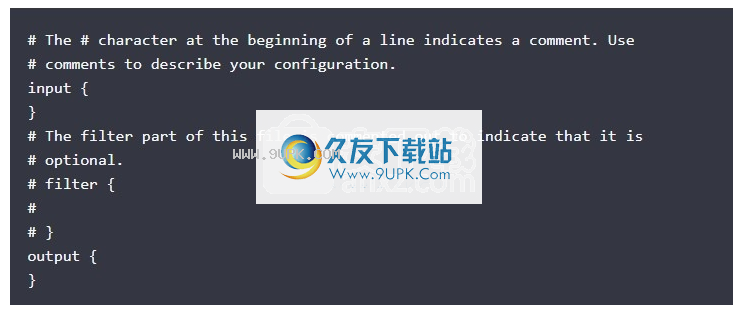

以下本表示配置管道的框架

该框架无法正常工作,因为在输入和输出部分中没有定义有效的选项。

首先,将框架配置管道复制并粘贴到first-pipeline.conf主Logstash目录中命名的文件中。

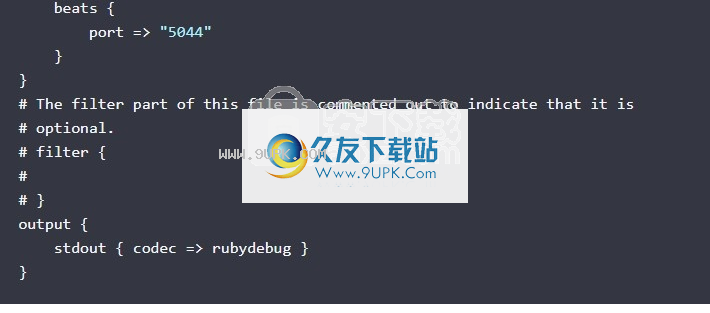

接下来,通过输入将以下行添加到first-pipeline.conf文件部分,以将Logstash实例配置为使用Beats inpu

t插件:

您将配置Logstash以在以后写入Elasticsearch。现在,您可以将以下行添加到输出部分,以在运行Logstash时将输出打印到stdout:

完成后,first-pipeline.conf的内容应如下所示:

要验证您的配置,请运行以下命令:

--config.test_and_exit选项解析您的配置文件并报告任何错误。

如果配置文件通过配置测试,请使用以下命令启动Logstash:

--config.reload.automatic选项启用自动重载配置,因此您不必在每次修改配置文件时都停止并重新启动Logstash。

当Logstash启动时,您可能会看到有关Logstash的一个或多个警告消息,而忽略了pipelines.yml文件。您可以放心地忽略此警告。 Pipelines.yml文件用于在单个Logstash实例中运行多个管道。对于此处显示的示例,您正在运行单个管道。

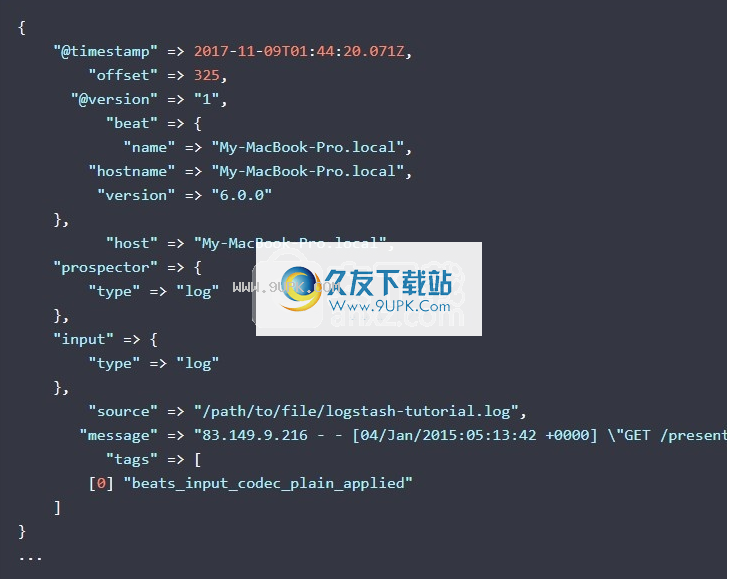

如果管道正常运行,您应该在控制台上看到一系列类似于以下事件:

软件功能:

收藏品等

输入,过滤和输出

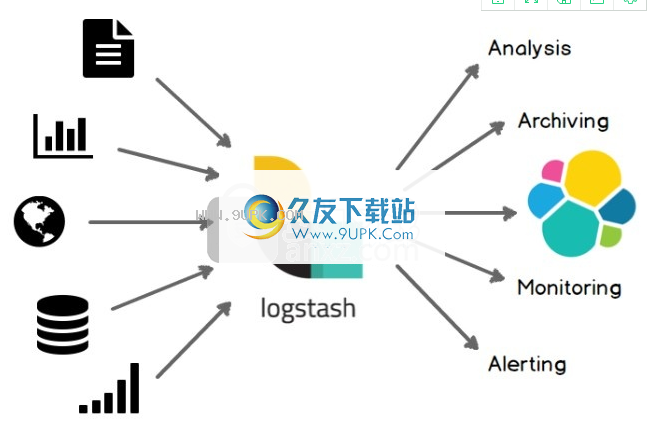

Logstash可以动态收集,转换和传输数据,而不考虑格式或复杂性。使用Grok从非结构化数据中获取结构,从IP地址解码地理坐标,匿名化或排除敏感字段,并简化整个处理过程。

输入

收集各种样式,大小和来源的数据

数据经常以分散或集中的各种形式存在于许多系统中。 Logstash支持各种输入选项,并且可以同时捕获来自许多常见来源的事件。您可以轻松地以连续流方式从日志,指标,Web应用程序,数据存储和各种AWS服务中收集数据。

筛选

实时分析和数据转换

在从源到存储库的数据传输过程中,Logstash过滤器能够解析事件,识别命名字段以构建结构,并将其转换为通用格式,以提供更强大的分析和商业价值。

Logstash可以动态转换和解析数据,而不考虑格式或复杂性:

使用Grok从非结构化数据得出结构

从IP地址解密地理坐标

匿名化PII数据并完全排除敏感字段

简化整体处理,而不受数据源,格式或结构的影响

使用我们丰富的过滤器库和通用的Elastic Common Schema,您可以实现无限的可能性。

输出

选择您的存储库,导出数据

尽管Elasticsearch是我们首选的输出方向,并且可以为我们的搜索和分析带来无限的可能性,但这并不是唯一的选择。

Logstash提供许多输出选项,您可以将数据发送到要指定的位置,并可以灵活地解锁许多下游用例。

可扩展

以自己的方式创建和配置管道。 Logstash使用可插拔框架,并具有200多个插件。您可以混合和匹配不同的输入选项,过滤器和输出选项,仔细排列它们,并使它们在管道中和谐地运行。

从自定义应用程序收集数据?找不到所需的插件吗? Logstash插件易于构建。我们拥有出色的插件开发API和插件生成器,可帮助您开始创建和共享结果。

软件特色:

即插即用

使用Elastic Stack更快地获取见解

Logstash模块通过流行的数据源(例如ArcSight和Netflow)提供即时的视觉体验。通过立即部署收集管道和复杂的仪表板,您可以在几分钟内开始数据探索。

建立可信的交付渠道

如果Logstash节点发生故障,Logstash将使用一个持久队列来确保正在运行的事件至少传递一次。那些未正常处理的消息将被发送到死信队列以进行进一步处理。具有吸收吞吐量的能力,现在您无需使用其他队列层,Logstash可以顺利通过高峰期。此外,我们还允许您完全确保收集管道的安全。

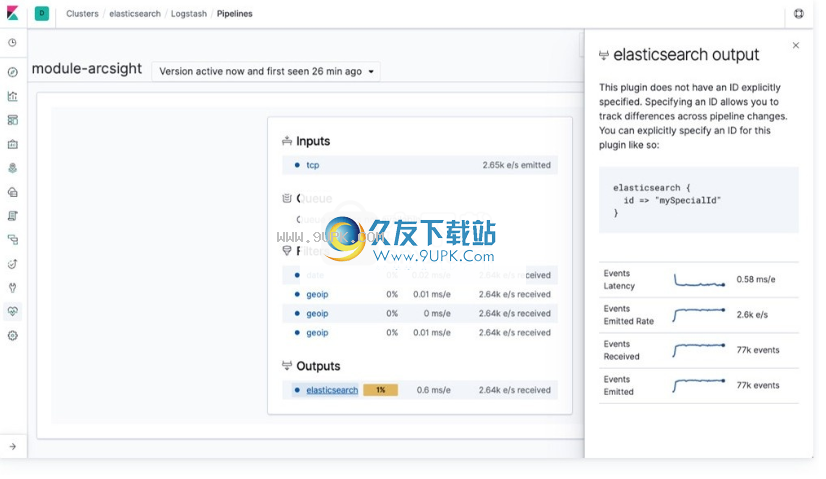

全面监控您的部署

Logstash管道通常有多种用途,并且可能变得非常复杂,因此充分了解管道性能,可用性和瓶颈非常重要。使用监视和管道查看器功能,您可以轻松观察和研究活动的Logstash节点或整个部署。

使用单个UI集中管理部署

借助管道管理形界面(UI)来管理Logstash的部署,您可以轻松地编排和管理自己的管道。此外,该管理功能与内置安全功能无缝集成,可避免任何意外操作

软件优势:

Logstash是具有实时管道功能的开源数据收集引擎。 Logstash可以动态统一来自不同来源的数据,并将数据标准化到您选择的目标位置。清除所有数据并使之民主化,以用于各种高级下游分析和可视化用例。

尽管Logstash最初促进了日志收集方面的创新,但其功能远远超出了用例。任何类型的事件都可以通过各种输入,过滤器和输出插件来丰富和转换,许多本机编解码器进一步简化了提取过程。 Logstash通过利用大量和多种数据来加快您的见解。

Logstash的功能是摄取Elasticsearch等的主要来源。

具有强大的Elasticsearch和Kibana协作功能的水平可扩展数据处理管道

可插拔管线架构

混合,匹配和编排不同的输入,过滤器和输出以协调管道

社区可扩展且对开发人员友好的插件生态系统

超过200个可用的插件,以及创建和贡献自己的灵活性日志和指标

从哪儿开始。

处理所有类型的日志数据

轻松获取大量Web日志(例如Apache)和应用程序日志(例如Java的log4j)

捕获许多其他日志格式,例如syslog,网络和防火墙日志等。

通过Filebeat享受补充安全日志转发功能

通过TCP和UDP从Ganglia,收集的NetFlow,JMX和许多其他基础架构和应用程序平台收集指标

互联网

解锁万维网。

将HTTP请求转换为事件

使用互联网服务(例如Twitter)进行社交情绪分析

Webhook对GitHub,HipChat,JIRA和无数其他应用程序的支持

启用许Watcher警报用例

通过按需轮询HTTP端点来创建事件

通常从Web应用程序界面捕获运行状况,性能,指标和其他类型的数据

非常适合控制轮询优先于接收的情况